熵是随机变量不确定性的度量,不确定性越大,熵值越大,若随机变量退化成定值,熵为0,均匀分布是最不确定的分布。熵其实定义了一个函数(概率分布函数)到一个值(信息熵)的映射。

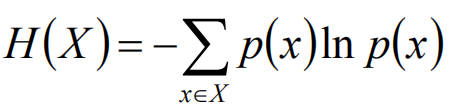

熵的定义公式如下:

在经典熵的定义中,底数是2,此时熵的单位是bit,若底数是e,则熵的单位是nat(奈特)

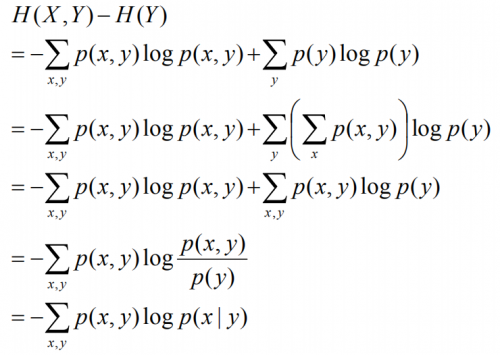

两个随机变量X, Y的联合分布,可以形成联合熵Joint Entropy,用H(X,Y)表示,那么我们不禁要问:H(X,Y) - H(Y)代表什么呢?

事实上,(X,Y)发生所包含的熵,减去Y单独发生包含的熵,在Y发生的前提下,X发生的新带来的熵。于是有了条件熵:H(X|Y)的定义

下面是条件熵的推导公式:

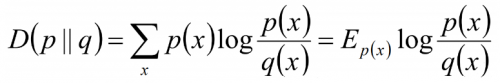

相对熵,又称为互熵,交叉熵,鉴别信息,KL散度,假设p(x), q(x)是X中取值的两个概率分布,则p对q的相对熵是:

对于相对熵,可以度量两个随机变量的距离,一般的p对q的相对熵和q对p的相对熵不相等。

对于已知的随机变量p,要使得相对简单的随机变量q,尽量接近p,那么我们可以采用相对熵进行求解:

假定使用KL(Q||P),为了让距离最小,则要求在P为0的地方,Q尽量为0。会得到比较“窄”的分布曲线;

假定使用KL(P||Q),为了让距离最小,则要求在P不为0的地方,Q也尽量不为0。会得到比较“宽”的分布曲线;

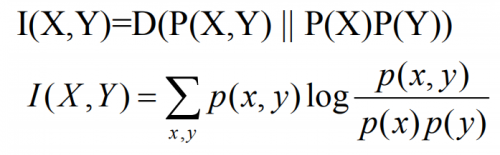

互信息

两个随机变量X,Y的互信息,定义为X,Y的联合分布和独立分布乘积的相对熵。

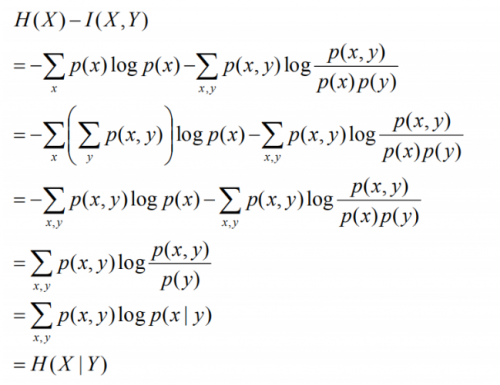

对于互信息,我们可以有如下的推导公式:

京公网安备 11010802030320号

京公网安备 11010802030320号